과정상세

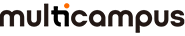

[주말반] 혁펜하임의 Easy! 딥러닝

교재제공 중급

[주말반] 혁펜하임의 Easy! 딥러닝

카테고리

- 학습유형별 대면

- AI

- AI 머신러닝/딥러닝

- AI 컴퓨터비전

- AI 자연어처리

과정요약

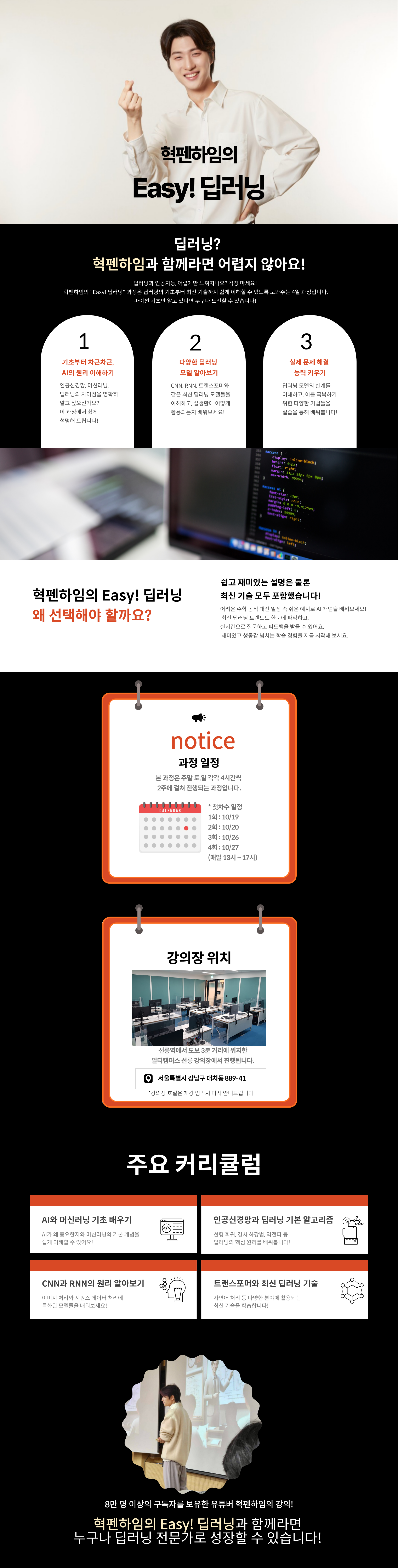

| 학습시간 | 16시간 | 난이도 | 중급 |

|---|---|---|---|

| 교육비 지원 | 고용보험 비환급 | 평가항목 | 출석률 100% |

| 수료기준 | 총점 80점 이상시 수료 | 정원 | 28 명 |

| 교재정보 | |||

과정소개

학습목표

- 인공 신경망, 선형 회귀, 경사 하강법부터 CNN, RNN, 트랜스포머까지 다양한 딥러닝 모델과 알고리즘의 작동 원리를 직관적으로 이해하고 설명할 수 있다. 특히 비유와 시각화를 통해 복잡한 개념을 쉽게 파악하고, 각 모델의 특징과 적용 사례를 구체적으로 서술할 수 있다.

- 역전파, 기울기 소실, 과적합 등 딥러닝의 핵심 개념과 문제점을 이해하고, 이를 해결하기 위한 다양한 기법(Adam, 배치 정규화, 드롭아웃 등)의 원리와 효과를 스스로 분석할 수 있다. 또한, 제시된 실험 결과를 바탕으로 각 기법의 효과성을 평가하고 해석할 수 있다.

- 강의 과정에서 스스로 의문을 제기하고 해결하는 능력을 기르며, 딥러닝 기술의 현재와 미래에 대해 비판적으로 사고할 수 있다. 또한, 학습한 내용을 바탕으로 실제 문제에 적합한 딥러닝 모델을 선택하고, 그 선택의 이유를 논리적으로 설명할 수 있다.

학습대상

- 파이썬 기초와 미분 수준의 수학 지식을 갖춘 AI 입문자

- 딥러닝의 기본 개념을 알고 있지만 심층적인 이해가 필요한 개발자나 연구자

- AI와 딥러닝 기술을 자신의 분야에 적용하고자 하는 타 분야 전문가

과정목차 16

-

1 일차

-

AI의 개요와 머신러닝 기초

-

AI vs ML vs DL

Rule-based vs Data-based

AI는 어떻게 이미지를 분류하고 번역할까?

지도 학습(Supervised Learning)

자기 지도 학습(Self-Supervised Learning)

강화 학습(Reinforcement Learning)

-

AI vs ML vs DL

-

AI의 개요와 머신러닝 기초

-

인공 신경망과 선형 회귀

-

인공 신경: Weight와 Bias의 직관적 이해

인공 신경망과 MLP

인공 신경망은 함수다!

선형 회귀, 개념부터 알고리즘까지 step by step

-

인공 신경: Weight와 Bias의 직관적 이해

-

경사 하강법(Gradient Descent)과 두 가지 문제

확률적 경사 하강법(Stochastic Gradient Descent)

Mini-Batch GD

Momentum

RMSProp (Root Mean Squared Propagation)

Adam (Adaptive Moment Estimation)

- 파이토치 실습

-

MLP의 비선형 액티베이션과 역전파

-

MLP, 행렬과 벡터로 표현하기

비선형(Non-Linear) 액티베이션의 중요성

역전파(Backpropagation)

-

MLP, 행렬과 벡터로 표현하기

-

Unit Step Function을 이용한 이진 분류

Unit Step Function의 두 가지 문제와 Sigmoid

Sigmoid를 이용한 이진 분류

BCE(Binary Cross-Entropy) Loss

로지스틱 회귀(Logistic Regression)

- 파이토치 실습

-

다중 분류(Multiclass Classification)

Softmax

Cross-Entropy Loss와 Softmax 회귀

-

다중 분류 실습

- 파이토치 실습

-

기울기 소실(Vanishing Gradient)과 과소적합(Underfitting)

ReLU(Rectified Linear Unit)

배치 정규화(Batch Normalization)

레이어 정규화(Layer Normalization)

Loss landscape 문제와 ResNet의 Skip-Connection

과적합(Overfitting)과 데이터 증강(Data Augmentation)

드랍아웃(Dropout)

정규화(Regularization)

-

CNN은 어떻게 인간의 사고방식을 흉내 냈을까?

이미지 인식에서 FC 레이어가 가지는 문제

컨볼루션(Convolution)의 동작 방식

컨볼루션은 어떻게 위치별 특징을 추출할까?

특징 맵(Feature Map)

어떤 특징을 추출할지 AI가 알아낸다!

다채널 입력에 대한 컨볼루션

1x1 컨볼루션의 의미

Padding & Stride

Pooling 레이어

CNN의 특징 맵 실험 결과 분석

-

VGGNet 완벽 해부

Receptive Field 개념과 여러 번 컨볼루션 레이어를 통과하는 이유

CNN에 대한 추가적인 고찰

-

CNN 실습

- 파이토치 실습

-

연속적인 데이터와 토크나이징(Tokenizing)

RNN의 동작 방식

다음 토큰 예측(Next Token Prediction)

RNN의 구조적 한계

RNN의 여러 가지 유형

-

Seq2seq 개념 및 문제점

Attention: 시점마다 다른 Context Vector의 사용

Attention: Context Vector 만들기

-

Attention의 학습 원리와 해석

RNN+Attention의 문제점

트랜스포머의 Self-Attention

수강후기 0

-

등록된 수강후기가 없습니다